인공지능(AI) 컴퓨팅 기술 선두 주자인 엔비디아가 엔비디아 HGX AI 슈퍼컴퓨팅 플랫폼을 구동하는 새로운 '엔비디아 A100 80GB GPU'를 공개했다.

이 제품은 6개월전에 출시한 모델보다 두배 높아진 메모리는 물론 연구자 및 엔지니어의 AI 혁신을 지원하는 전례 없는 속도와 성능을 제공한다.

|

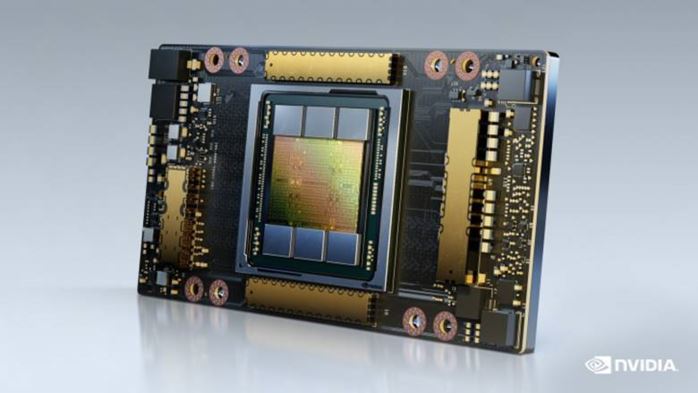

| ▲ 엔비디아 A100 80GB GPU. |

HBM2e 기술이 적용된 이 제품은 A100 40GB GPU의 고대역폭 메모리를 두배인 80GB로 늘리고, 초당 2테라바이트(TB) 이상의 메모리 대역폭을 제공한다.

이를 통해 세계에서 가장 빠른 데이터센터 GPU인 A100에 데이터를 신속하게 공급해 연구자들이 앱을 더욱 빠르게 가속화하고, 대규모의 모델 및 데이터셋을 활용할 수 있도록 한다.

엔비디아 응용 딥 러닝 리서치부문 부사장 브라이언 카탄자로(Bryan Catanzaro)는 “고성능 컴퓨팅(HPC)과 AI 분야에서 최상의 연구 결과를 내기 위해서는 방대한 모델을 구축해야 하는데, 이는 어느 때보다 더 높은 메모리 용량과 대역폭을 요구하고 있다"며 "이 제품은 이전 모델 보다 두배 높은 메모리를 제공한다. 또 초당 2TB의 속도로 연구자들이 중요한 과학 및 빅 데이터 과제를 해결하도록 돕는다”고 말했다.

이 제품은 함께 발표된 '엔비디아 DGX A100'과 'DGX 스테이션 A100(DGX Station A100)' 시스템에서 이용 가능하며, 해당 제품들은 올 4분기에 출하될 예정이다.

업계 선도적인 시스템 공급업체인 아토스(Atos), 델 테크놀로지스(Dell Technologies), 후지쯔(Fujitsu), 기가바이트(GIGABYTE), HPE, 인스퍼(Inspur), 레노버(Lenovo), 퀀타(Quanta), 슈퍼마이크로(Supermicro)는 내년상반기부터 이 제품이 탑재된 HGX A100 통합 베이스보드로 구축된 시스템을 제공할 계획이다.

■ 방대한 데이터 워크로드 지원

A100 80GB GPU는 40GB 버전의 다양한 기능을 기반으로 설계됐으며, 막대한 데이터 메모리를 요구하는 광범위한 앱에 이상적이다.

AI 훈련에 있어 DLRM과 같은 추천 시스템 모델에는 수십억 명의 사용자와 수십억 개의 제품을 나타내는 방대한 테이블을 포함하고 있다. 이 제품은 최대 3배 빠른 속도를 제공하므로 기업은 이러한 유형의 모델을 신속하게 재훈련해 매우 정확한 추천 서비스를 제공할 수 있다.

A100 80GB GPU는 뛰어난 언어 생성 기능을 갖춘 GPT-2 자연어 처리 모델과 같이 단일 HGX 탑재 서버에서 더 많은 매개변수를 가진 방대한 모델을 훈련할 수 있다. 이를 통해 구현에 많은 시간이 소요되고, 여러 노드에서 느리게 실행될 수 있는 데이터 혹은 모델을 위한 병렬처리 아키텍처의 필요성을 없앤다.

A100은 멀티 인스턴스 GPU(MIG) 기술을 통해 최대 7개의 GPU 인스턴스로 분할할 수 있으며, 각각의 인스턴스는 10GB 메모리를 갖는다. 해당 기술은 안전한 하드웨어 격리를 제공하고, 다양한 소규모 워크로드를 위해 GPU 활용도를 극대화한다. RNN-T와 같은 자동 음성 모델의 AI 추론의 경우, 단일 A100 80GB MIG 인스턴스가 훨씬 더 큰 배치 사이즈를 작업해 1.25배 더 많은 추론 처리량을 제공한다.

이 제품은 TB 규모의 리테일용 빅데이터 분석 벤치마크에서 최대 2배로 높은 성능을 달성하며, 가장 큰 데이터셋에서 신속한 통찰력을 제공하는 이상적인 플랫폼임을 입증했다. 이를 통해 기업들은 동적으로 데이터가 업데이트됨에 따라 실시간으로 주요 의사결정을 내릴 수 있다.

A100 80GB GPU는 기상 예측과 양자 화학과 같은 분야의 과학 애플리케이션을 빠르게 가속화할 수 있다. 소재 시뮬레이션인 퀀텀 에스프레소(Quantum Espresso)는 A100 80GB GPU의 단일 노드로 성능을 두배 가까이 향상시켰다.

마쓰오카 사토시(Satoshi Matsuoka) 일본 이화학연구소(RIKEN) 컴퓨터 사이언스 센터 이사는 “빠르고 충분한 메모리 대역폭과 용량은 슈퍼컴퓨팅 앱의 높은 성능을 구현하는데 필수적이다. 세계 최고 수준으로, 초당 2TB 대역폭을 제공하는 HBM2e GPU 메모리를 갖춘 엔비디아 A100 80GB GPU는 앱 성능을 향상시키는 데 상당한 도움이 될 것”이라고 설명했다.

■ A100 80GB GPU의 주요 특징

A100 80GB GPU는 획기적인 엔비디아 암페어(Ampere) 아키텍처의 여러 기능을 포함한다.

→ 3세대 텐서 코어(Tensor Core)/ 새로운 TF32 형식, 2.5배 뛰어난 HPC 성능을 제공하는 FP64, 20배 향상된 AI 추론을 지원하는 INT8, BF16 데이터 포맷을 지원한다. 이를 통해 볼타(Volta) V100 대비 20배 높은 AI 처리량을 제공한다.

→ 더 크고 빠른 HBM2e GPU 메모리/ 메모리 용량을 2배 늘려 업계 최초로 초당 2TB 이상의 메모리 대역폭을 제공한다.

→ MIG 기술/ 격리된 인스턴스 당 메모리를 두 배로 늘려 각각 10GB 메모리를 갖는 최대 7개의 GPU를 제공한다.

→ 구조적 희소성/ 희소 모델(sparse model)을 추론하는 속도를 최대 2배까지 향상시킨다.

→ 3세대 NV링크(NVLink) 및 NV스위치(NVSwitch)/ 이전 세대 연결 기술에 비해 2배 높은 GPU-투-GPU 대역폭을 제공함으로써 데이터 집약적 워크로드를 위해 GPU로의 데이터 전송을 초당 600GB로 가속화한다.

■ 엔비디아 HGX AI 슈퍼컴퓨팅 플랫폼

A100 80GB GPU는 엔비디아 GPU, 엔비디아 NV링크, 엔비디아 인피니밴드(InfiniBand) 네트워킹과 완벽하게 최적화된 엔비디아 AI, HPC 소프트웨어 스택을 통해 최상의 AI 애플리케이션 성능을 제공한다. 이를 통해 연구자와 과학자들은 HPC, 데이터 애널리틱스, 딥 러닝 컴퓨팅 방법을 통합해 과학적 발전을 도모할 수 있다.

■ 엔비디아(NVIDIA)는?

1999년 GPU를 발명해 PC게임 시장 성장에 핵심적인 역할을 했으며, 현대적 컴퓨터 그래픽을 재정의하고 병렬 컴퓨팅의 변혁을 일으켰다. 최근 GPU 딥 러닝은 컴퓨팅의 다음 시대라 할 수 있는 현대적 인공지능(AI)의 포문을 열었다. GPU는 컴퓨터와 로봇, 자율주행차 등에 탑재돼 세계를 인지하고 이해할 수 있도록 돕는 뇌 역할을 하고 있다. 자세한 내용은 엔비디아 코리아 홈페이지(www.nvidia.co.kr) 및 엔비디아 코리아 공식 SNS에서 확인할 수 있다. [플랫폼뉴스 정기홍 기자]

저작권자 ⓒ 플랫폼뉴스, 무단 전재 및 재배포 금지